Bạn có bao giờ thắc mắc làm thế nào để nhóm các dữ liệu tương tự lại với nhau mà không cần phải gán nhãn trước? Phân cụm chính là thuật toán giúp khám phá các mẫu dữ liệu ẩn và tổ chức chúng thành các nhóm thông minh. Cùng Learning Chain, tìm hiểu cách phân cụm có thể thay đổi cách bạn nhìn nhận dữ liệu và giúp phát triển kỹ năng trong công nghệ!

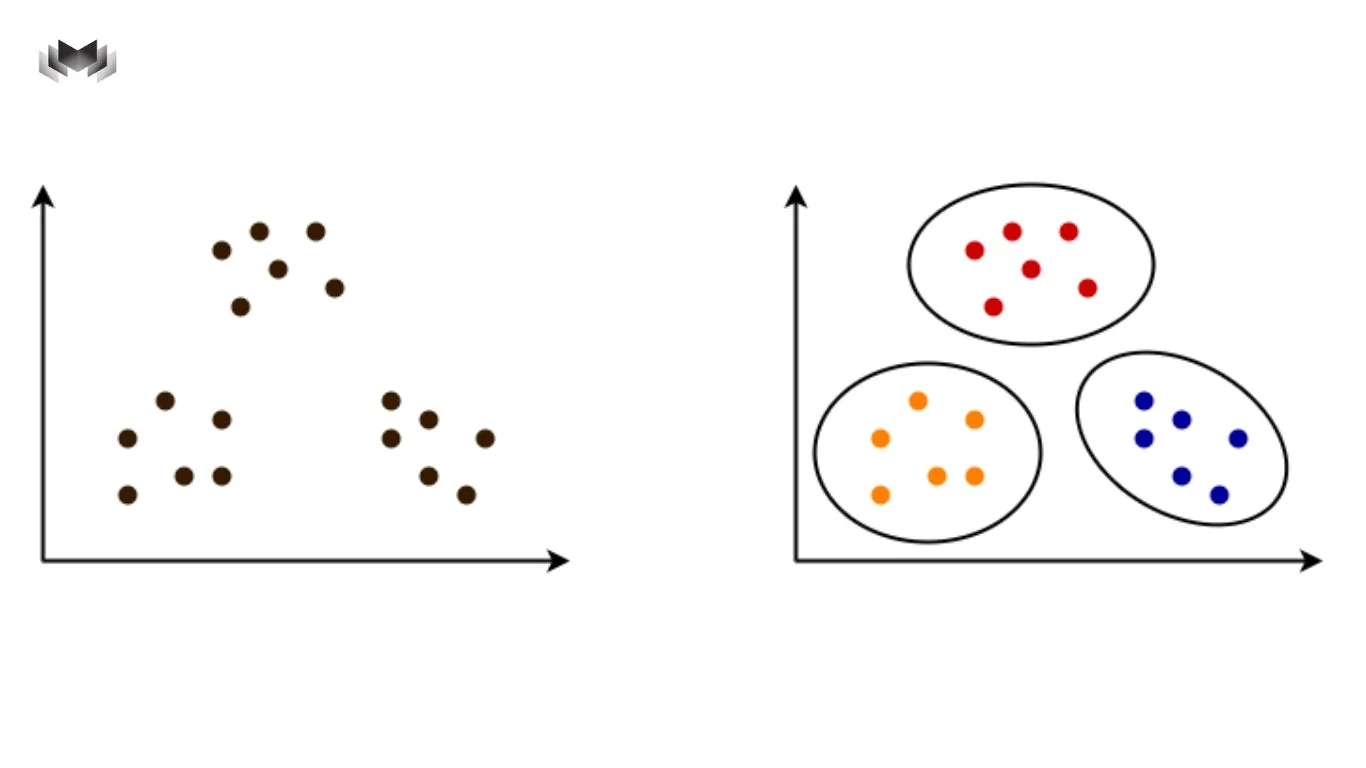

Thuật toán phân cụm hay clustering, thuộc phương pháp clustering trong unsupervised learning. Điều đó có nghĩa là dữ liệu đầu vào không đi kèm đáp án, và hệ thống phải tự khám phá cấu trúc ẩn của dữ liệu. Thuật toán chỉ được cung cấp các đặc trưng như hành vi, thuộc tính, chỉ số đo lường… rồi tự tìm cách nhóm những điểm giống nhau lại.

Mục tiêu chung của các thuật toán phân cụm là làm sao để các điểm trong cùng một cụm thì giống nhau nhất có thể, còn giữa các cụm thì khác nhau càng rõ càng tốt. Từ đó, cấu trúc ẩn của dữ liệu dần lộ diện.

Thay vì hỏi dữ liệu này đúng hay sai, phân cụm trả lời những câu hỏi mang tính khám phá hơn, như: dữ liệu này có bao nhiêu kiểu hành vi khác nhau, những nhóm nào đang tồn tại song song, hay đâu là những điểm lệch khỏi số đông.

Khi đi sâu hơn, bạn sẽ thấy phân cụm không chỉ có một cách làm duy nhất. Tùy vào dữ liệu và bài toán, người ta thường chọn giữa ba hướng tiếp cận phổ biến trong một loại thuật toán machine learning chuyên biệt cho việc nhóm dữ liệu.

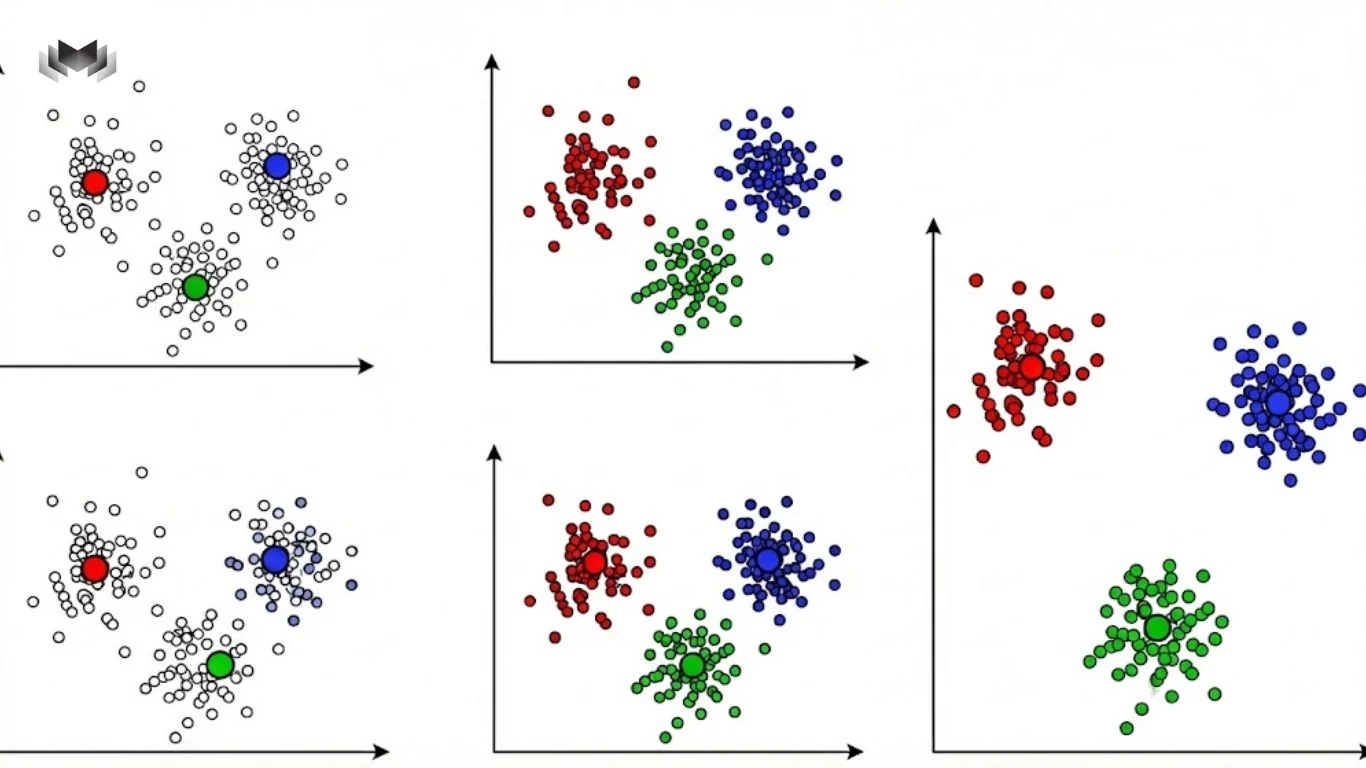

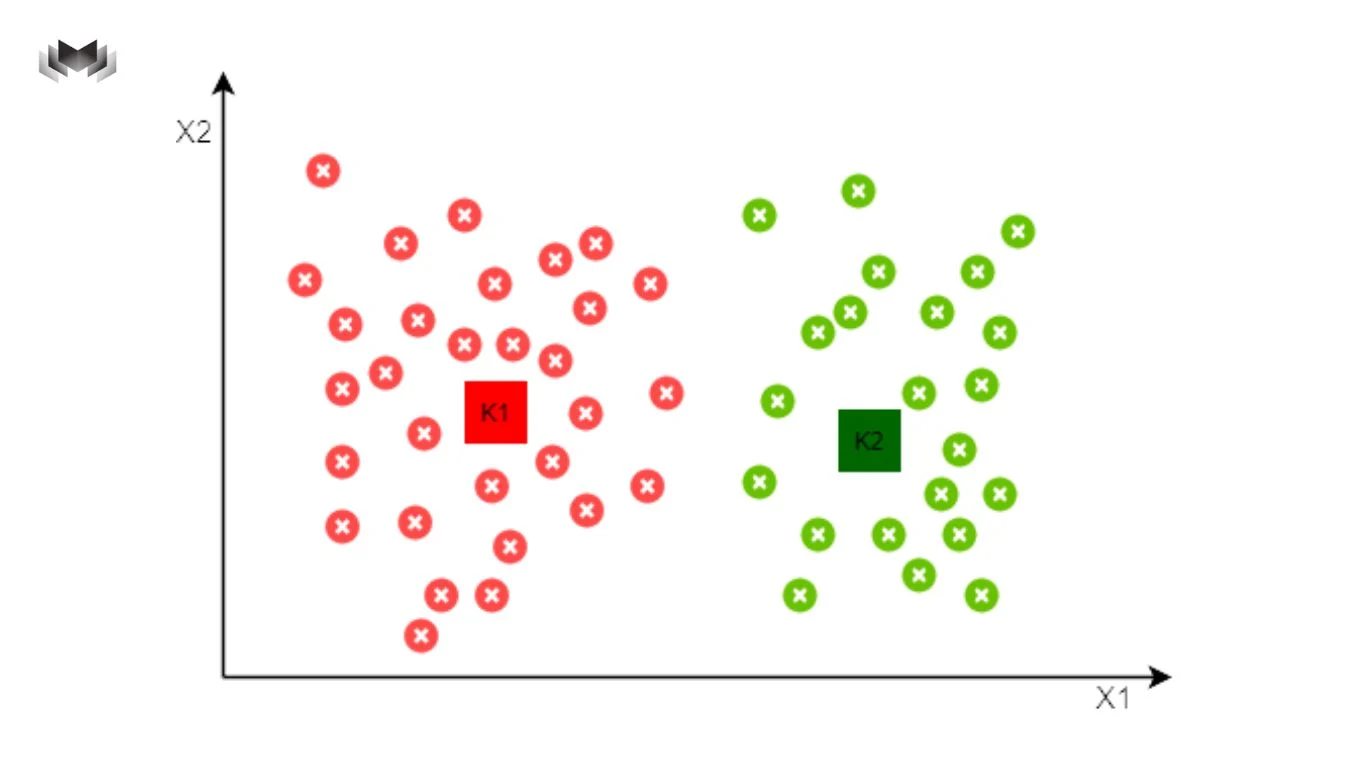

Đây thường là điểm bắt đầu của rất nhiều người, với cái tên quen thuộc là K-Means. Cách làm của K-Means khá dễ hình dung: bạn chọn trước số nhóm mình muốn, rồi thuật toán sẽ tự tìm cách gom các điểm dữ liệu sao cho mỗi điểm nằm gần trung tâm nhóm của nó nhất.

K-Means hoạt động tốt khi dữ liệu tương đối “ngoan”, các nhóm không quá méo mó và kích thước các cụm khá đồng đều. Vì vậy, nó hay được dùng trong các bài toán đời thường như chia khách hàng thành vài nhóm hành vi, gom sản phẩm theo đặc điểm sử dụng, hay phân loại người dùng theo mức độ tương tác.

Trong quá trình làm việc, nhiều người nhận ra rằng K-Means nhanh, dễ dùng nhưng cũng khá nhạy cảm với nhiễu. Lúc đó, K-Medoids thường được mang ra cân nhắc. Thay vì lấy trung bình làm trung tâm, K-Medoids chọn luôn một điểm dữ liệu thật làm đại diện cho cụm. Cách này giúp kết quả ổn định hơn khi dữ liệu có những điểm “lệch chuẩn”.

Có những lúc bạn không muốn ép dữ liệu vào một số nhóm cố định ngay từ đầu. Bạn muốn nhìn xem các nhóm lớn được tạo thành từ những nhóm nhỏ nào, và mối quan hệ giữa chúng ra sao. Khi đó, phân cụm phân cấp trở thành lựa chọn hợp lý.

Thay vì trả lời ngay câu hỏi có bao nhiêu cụm, thuật toán này xây dựng dần một cấu trúc giống như cây gia phả của dữ liệu. Có cách bắt đầu từ từng điểm riêng lẻ rồi gộp dần lại, cũng có cách bắt đầu từ một khối lớn rồi tách nhỏ ra.

Điểm hay của phân cụm phân cấp là bạn có thể “zoom” dữ liệu ở nhiều mức độ khác nhau. Khi nhìn tổng thể, bạn thấy vài nhóm lớn. Khi đi sâu, bạn lại thấy các nhóm con bên trong. Kiểu tiếp cận này rất phù hợp khi mục tiêu là khám phá mối quan hệ, thay vì chỉ chia dữ liệu cho gọn.

Không phải lúc nào dữ liệu cũng xếp thành những cụm tròn trịa, dễ nhìn. Trong nhiều hệ thống thực tế, dữ liệu có hình dạng rất phức tạp, chỗ thì dày đặc, chỗ thì thưa thớt. Đây là lúc các thuật toán như DBSCAN phát huy thế mạnh.

Thay vì cố gắng chia dữ liệu thành số nhóm cố định, DBSCAN đi tìm những vùng có mật độ điểm cao. Những vùng này được coi là cụm, còn các điểm đứng lẻ loi bên ngoài thì bị xem là nhiễu.

Điều thú vị là trong nhiều bài toán an ninh hay phát hiện gian lận, chính những điểm bị xem là nhiễu này lại quan trọng nhất. Chúng đại diện cho hành vi bất thường, giao dịch đáng ngờ hoặc dấu hiệu sớm của sự cố. Nhờ cách nhìn dựa trên mật độ, dữ liệu không còn bị ép vào khuôn, mà được hiểu theo đúng bản chất của nó.

Vì dữ liệu không có nhãn, nên việc đánh giá chất lượng phân cụm không hề đơn giản. Thay vì đúng sai tuyệt đối, người ta dùng các chỉ số để đo mức độ hợp lý của cách chia.

Silhouette Score là một chỉ số phổ biến, phản ánh mức độ một điểm dữ liệu phù hợp với cụm của nó so với các cụm khác. Giá trị càng cao thì phân cụm càng rõ ràng.

Davies – Bouldin Index đo mức độ phân biệt giữa các cụm, với giá trị thấp thể hiện các cụm tách biệt tốt. Dunn Index thì tập trung vào khoảng cách giữa các cụm so với độ rộng bên trong cụm.

Trong thực tế, không có chỉ số nào là hoàn hảo. Các nhóm thường kết hợp nhiều cách đo và cả trực giác nghiệp vụ để đánh giá kết quả. Việc đánh giá này có điểm tương đồng với cách so sánh clustering và classification trong học có giám sát, nơi mỗi phương pháp có tiêu chí riêng phù hợp với bài toán cụ thể.

Một trong những câu hỏi đau đầu nhất khi dùng K-Means là nên chọn bao nhiêu cụm. Nếu chọn quá ít, dữ liệu bị gom thô. Nếu chọn quá nhiều, mô hình trở nên rối rắm.

Phương pháp Elbow là cách được nhắc đến nhiều nhất. Bằng cách vẽ đồ thị tổng khoảng cách theo số cụm, người phân tích tìm điểm mà lợi ích tăng thêm bắt đầu chậm lại.

Silhouette Score cũng thường được dùng để so sánh các giá trị K khác nhau và chọn mức cho chất lượng tốt nhất. Gap Statistic thì so sánh kết quả phân cụm với dữ liệu ngẫu nhiên để xem cấu trúc tìm được có thực sự ý nghĩa hay không. Trong một số trường hợp phức tạp, phương pháp xác suất trong phân cụm còn giúp ước lượng độ không chắc chắn của từng cụm và xác suất một điểm thuộc về cụm nào.

Khi nhắc đến phân cụm, nhiều người hay nghĩ đây là một kỹ thuật thuần kỹ thuật, chỉ dành cho dân dữ liệu hay lập trình. Nhưng khi quan sát kỹ hơn, bạn sẽ thấy phân cụm xuất hiện rất nhiều trong những quyết định quen thuộc hằng ngày, từ cách doanh nghiệp hiểu khách hàng cho đến cách hệ thống phát hiện rủi ro.

Điểm hay của thuật toán phân cụm nằm ở chỗ nó giúp con người nhìn thấy cấu trúc ẩn trong dữ liệu – những mối liên hệ mà nếu chỉ nhìn bằng bảng số liệu thì rất khó nhận ra.

Trong kinh doanh, phân cụm thường được dùng để trả lời một câu hỏi rất đời: khách hàng của mình thực sự giống nhau hay khác nhau ở điểm nào. Thay vì nhìn tất cả khách hàng như một khối đồng nhất, doanh nghiệp dùng phân cụm để tách họ thành các nhóm dựa trên hành vi mua sắm, thói quen tiêu dùng, mức chi tiêu hay tần suất quay lại. Khi đó, mỗi nhóm sẽ có nhu cầu và cách tiếp cận khác nhau.

Chẳng hạn, một công ty bán lẻ có thể nhận ra rằng có nhóm khách mua ít nhưng rất đều, nhóm mua nhiều nhưng chỉ vào dịp khuyến mãi, và nhóm chỉ ghé xem chứ hiếm khi mua. Nhờ phân cụm, chiến lược tiếp thị không còn là gửi một thông điệp cho tất cả, mà là nói đúng điều, đúng thời điểm, với đúng nhóm người.

Trong lĩnh vực tài chính, phân cụm giúp tổ chức dữ liệu theo mức độ rủi ro thay vì chỉ dựa vào vài tiêu chí cứng nhắc. Các ngân hàng và công ty tài chính thường dùng phân cụm để nhóm khách hàng có hành vi tài chính tương tự nhau.

Những nhóm này có thể khác nhau về khả năng thanh toán, thói quen chi tiêu hoặc mức độ ổn định thu nhập. Từ đó, hệ thống hỗ trợ việc chấm điểm tín dụng, phát hiện giao dịch bất thường hoặc đưa ra chính sách vay phù hợp hơn cho từng nhóm.

Ở đây, phân cụm không thay thế con người ra quyết định, mà đóng vai trò lọc và sắp xếp thông tin, giúp chuyên viên tài chính nhìn rõ bức tranh tổng thể nhanh hơn.

Một trong những ứng dụng rất thực tế của phân cụm là phát hiện những hành vi khác thường. Trong các hệ thống bảo mật, phần lớn dữ liệu là những hoạt động bình thường lặp đi lặp lại mỗi ngày. Phân cụm giúp hệ thống hiểu đâu là hành vi quen thuộc, đâu là mẫu hình phổ biến. Khi một điểm dữ liệu không thuộc về bất kỳ cụm nào hoặc nằm rất xa so với các cụm còn lại, đó có thể là dấu hiệu của gian lận, tấn công mạng hoặc hành vi bất thường.

Ví dụ, trong ngân hàng trực tuyến, những giao dịch đến từ vị trí lạ, thời điểm lạ hoặc có giá trị bất thường sẽ dễ bị phát hiện hơn khi đặt trong bối cảnh của các cụm hành vi thông thường.

Không chỉ với con người, phân cụm còn giúp dữ liệu trở nên “dễ sống chung” hơn. Khi làm việc với hàng nghìn hoặc hàng triệu tài liệu, việc tìm kiếm từng mục riêng lẻ trở nên rất tốn thời gian.

Phân cụm cho phép hệ thống gom các tài liệu có nội dung tương tự lại với nhau. Nhờ đó, việc tìm kiếm, gợi ý hoặc khám phá thông tin trở nên nhanh và tự nhiên hơn. Người dùng không cần biết chính xác mình cần gì, chỉ cần bắt đầu từ một cụm nội dung gần với nhu cầu là đã có thể lần ra thông tin mong muốn.

Trong y tế và sinh học, phân cụm đóng vai trò như một công cụ hỗ trợ khám phá. Các nhà nghiên cứu sử dụng phân cụm để nhóm bệnh nhân, mẫu xét nghiệm hoặc dữ liệu gen dựa trên sự tương đồng về đặc điểm sinh học.

Nhờ cách tiếp cận này, những mẫu hình khó thấy bằng mắt thường dần hiện ra. Trong nghiên cứu ung thư, chẳng hạn, phân cụm giúp chia bệnh nhân thành các nhóm có đặc điểm di truyền tương đồng, từ đó hỗ trợ lựa chọn phác đồ điều trị phù hợp hơn cho từng nhóm.

Ở đây, phân cụm không thay thế bác sĩ hay nhà khoa học, mà giúp họ có thêm một lớp thông tin để đưa ra quyết định chính xác hơn.

Phân cụm không chỉ là một thuật toán, mà là một cách tư duy. Nó dạy chúng ta quan sát dữ liệu trước khi kết luận, hiểu cấu trúc trước khi dự đoán. Với nhiều người trong cộng đồng Learning Chain, làm chủ phân cụm là bước chuyển từ việc dùng AI theo hướng công thức sang việc thực sự hiểu dữ liệu mình đang làm việc cùng.

Khi bạn nhìn được dữ liệu đang tự nói gì với mình, AI không còn là chiếc hộp đen. Nó trở thành công cụ hỗ trợ tư duy, giúp bạn ra quyết định tốt hơn trong kinh doanh, công nghệ và cả nghiên cứu. Và từ chính những cụm dữ liệu tưởng như rời rạc đó, rất nhiều câu chuyện có giá trị đã bắt đầu.

CÂU HỎI THƯỜNG GẶP

Khi nào thì phân cụm hữu ích hơn việc dự đoán hay phân loại?

Khi bạn chưa thật sự biết mình đang tìm gì trong dữ liệu. Phân cụm phù hợp ở giai đoạn khám phá, giúp lộ ra các nhóm hành vi, cấu trúc ẩn hoặc điểm bất thường trước khi đặt giả thuyết cụ thể.

Vì sao phân cụm thường là bước đầu tiên trước khi làm các bài toán AI khác?

Vì nó giúp “hiểu dữ liệu trước khi tin dữ liệu”. Khi biết dữ liệu đang có những nhóm nào, khác nhau ở đâu, bạn sẽ chọn được mô hình dự đoán phù hợp hơn và tránh xây AI trên những giả định sai.

K-Means, Hierarchical và DBSCAN khác nhau ở điểm cốt lõi nào?

K-Means phù hợp khi muốn chia dữ liệu nhanh, gọn theo số nhóm định sẵn; phân cụm phân cấp phù hợp khi muốn nhìn mối quan hệ nhiều tầng giữa các nhóm; DBSCAN mạnh khi dữ liệu có hình dạng phức tạp và khi việc phát hiện điểm bất thường quan trọng hơn việc chia cho đều.