Bạn đã bao giờ tự hỏi làm sao một mô hình có thể đưa ra dự đoán ổn định ngay cả khi dữ liệu nhiễu và khó đoán? Random Forest là thuật toán làm được điều đó nhờ cách kết hợp nhiều cây quyết định độc lập. Từ góc nhìn được Learning Chain tổng hợp, mô hình này giúp giảm overfitting, tăng độ chính xác và hoạt động hiệu quả trong cả phân loại lẫn hồi quy.

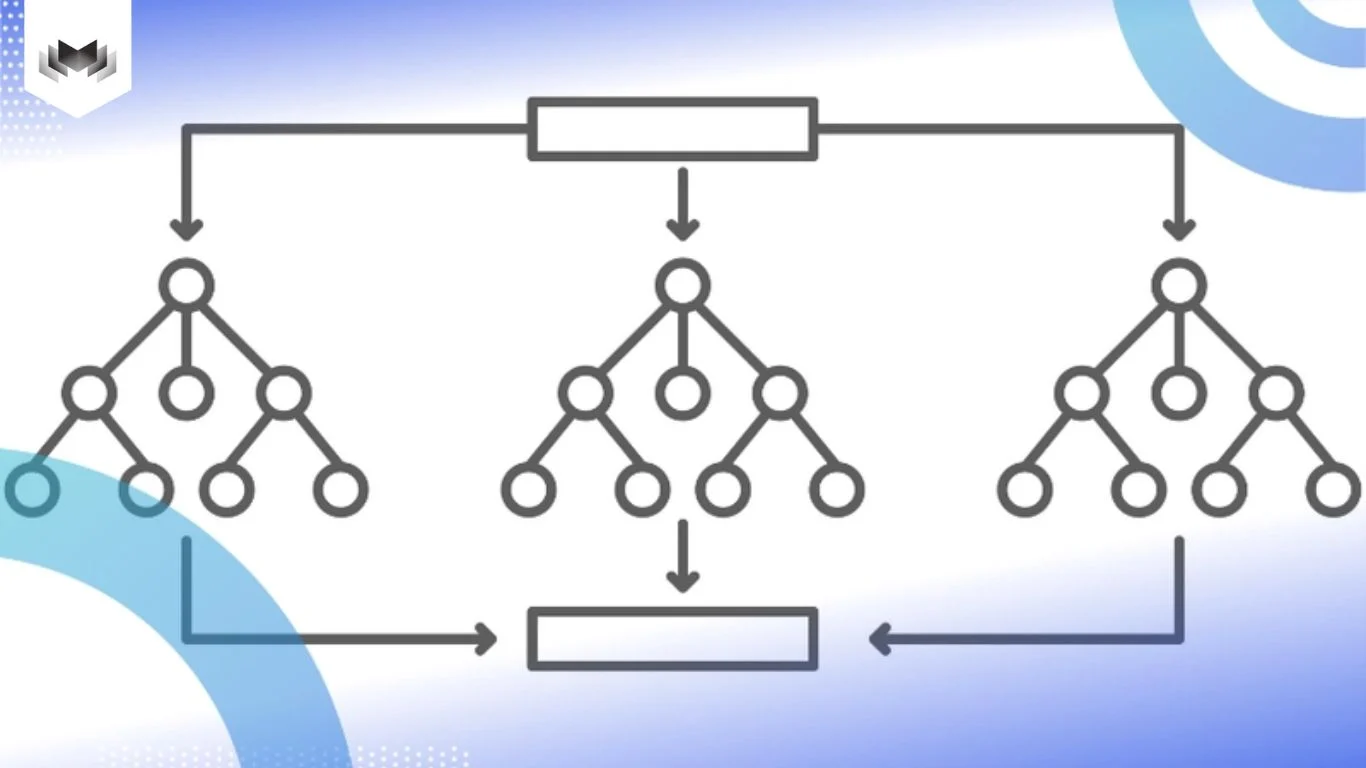

Random Forest là một thuật toán supervised learning phổ biến, hoạt động dựa trên việc kết hợp nhiều cây quyết định độc lập để tạo thành một mô hình mạnh mẽ và ổn định. Mỗi cây giống như một người đưa ra ý kiến riêng, còn cả khu rừng sẽ tổng hợp lại để đi đến kết luận chung. Nhờ vậy, Random Forest thường cho kết quả đáng tin cậy hơn so với việc chỉ dùng một cây quyết định đơn lẻ, đặc biệt trong các bài toán phân loại và hồi quy.

Ở Learning Chain, tụi mình hay ví Random Forest như việc hỏi ý kiến nhiều người trước khi quyết định: mỗi người có thể sai ở đâu đó, nhưng khi tổng hợp lại, khả năng sai lệch sẽ giảm đi đáng kể.

Bạn có thể hình dung Random Forest như một nhóm rất nhiều cây quyết định cùng làm việc song song. Mỗi cây không học toàn bộ dữ liệu, mà chỉ được “xem” một phần dữ liệu được chọn ngẫu nhiên. Khi đến lúc chia nhánh, cây cũng chỉ cân nhắc một vài đặc trưng thay vì nhìn tất cả.

Nhờ cách học này, mỗi cây hình thành một góc nhìn riêng về dữ liệu. Có cây nhạy với nhóm đặc trưng này, có cây lại mạnh ở nhóm khác. Random Forest không chọn tin vào một cây duy nhất, mà gom tất cả các ý kiến đó lại để đưa ra kết quả cuối cùng.

Chính sự đa dạng giữa các cây giúp mô hình bớt phụ thuộc vào một góc nhìn đơn lẻ, từ đó giảm overfitting và cho kết quả ổn định hơn khi gặp dữ liệu mới. Cách tiếp cận này khác với so sánh random forest và neural network, nơi neural network học các đặc trưng phức tạp qua nhiều lớp ẩn.

Ở Learning Chain, tụi mình hay ví Random Forest như một buổi họp nhóm đông người. Thay vì chỉ nghe ý kiến của một người duy nhất, mô hình này mời rất nhiều “cây quyết định” cùng tham gia, mỗi cây nhìn dữ liệu theo một góc khác nhau. Cuối cùng, cả nhóm bỏ phiếu để đi đến kết luận chung. Để làm được điều đó, Random Forest vận hành qua vài bước khá thú vị.

Thay vì đưa toàn bộ dữ liệu cho tất cả các cây, Random Forest chia dữ liệu ra theo kiểu ngẫu nhiên. Mỗi cây được huấn luyện trên một tập con dữ liệu được chọn lại, nghĩa là có dòng xuất hiện nhiều lần, có dòng thì không xuất hiện lần nào.

Ví dụ:

Bạn có 1.000 hồ sơ khách hàng vay vốn.

Cây A có thể học từ hồ sơ số 25 đến 3 lần.

Cây B lại không hề thấy hồ sơ số 200.

Nhìn vậy nghe có vẻ lộn xộn, nhưng chính sự khác nhau này khiến mỗi cây có trải nghiệm riêng, giống như mỗi người trong cộng đồng nhìn vấn đề từ một hoàn cảnh khác nhau.

Khi một cây cần chia nhánh, nó không nhìn toàn bộ đặc trưng có sẵn. Thay vào đó, nó chỉ chọn ngẫu nhiên một vài đặc trưng để cân nhắc.

Ví dụ

Trong bài toán duyệt vay với 20 thông tin như tuổi, thu nhập, điểm tín dụng, nghề nghiệp, lịch sử nợ…

Mỗi lần quyết định, cây chỉ xem khoảng 4 – 5 yếu tố được chọn ngẫu nhiên.

Cách này giống như việc mỗi người trong nhóm chỉ tập trung vào vài khía cạnh mà họ hiểu rõ nhất. Người thì nhìn thu nhập, người thì để ý lịch sử tín dụng, người khác lại quan tâm đến độ ổn định công việc. Nhờ vậy, cả “khu rừng” không bị lệch về một góc nhìn duy nhất.

Vì dữ liệu và đặc trưng khác nhau, mỗi cây sẽ học ra một kiểu logic khác nhau.

Có cây học rất rõ về nhóm khách hàng trẻ.

Có cây lại “quen mặt” với nhóm thu nhập cao.

Có cây đặc biệt nhạy với những trường hợp từng có nợ xấu.

Không cây nào đúng tuyệt đối, nhưng mỗi cây đều đóng góp một phần góc nhìn.

Khi cần dự đoán, tất cả các cây cùng đưa ra ý kiến.

Nếu là bài toán phân loại, Random Forest chọn kết quả được nhiều cây đồng ý nhất.

Nếu là hồi quy, mô hình lấy trung bình kết quả của các cây.

Ví dụ:

dự đoán một khách hàng có được duyệt vay hay không:

Cây 1 nói có

Cây 2 nói không

Cây 3 nói có

Cây 4 nói có

Ba trên bốn cây đồng ý → kết luận cuối là có.

Chính cách “nghe nhiều ý kiến rồi mới quyết” này giúp Random Forest ổn định hơn, ít bị nhiễu và đáng tin hơn so với việc đặt cược vào một cây duy nhất. Với Learning Chain, đây là lý do Random Forest thường được chọn cho những bài toán thực tế, nơi dữ liệu không hoàn hảo và quyết định cần đủ chắc để dùng lâu dài.

Các buổi trao đổi trong cộng đồng Learning Chain, chúng mình thấy Random Forest thường được chọn không phải vì nó “ngầu” hay phức tạp, mà vì làm việc rất ổn trong môi trường dữ liệu ngoài đời. Dữ liệu có thể thiếu, có thể nhiễu, có thể không đẹp, nhưng mô hình này vẫn chạy khá chắc tay.

Random Forest không dựa vào một cây quyết định duy nhất mà gom ý kiến của rất nhiều cây khác nhau. Mỗi cây nhìn dữ liệu theo một góc riêng, rồi cả rừng cùng bỏ phiếu. Nhờ vậy, mô hình ít khi bị học quá sát dữ liệu cũ và dự đoán lệch khi gặp dữ liệu mới.

Làm dữ liệu thật rồi sẽ hiểu, thiếu cột, thiếu giá trị là chuyện rất bình thường. Random Forest xử lý mấy tình huống này khá ổn mà không cần phải can thiệp quá nhiều ở bước tiền xử lý. Điều này giúp tiết kiệm thời gian và công sức khi triển khai.

Có những bài toán mà mối quan hệ giữa các biến không hề thẳng thắn hay rõ ràng. Nhờ cấu trúc từ nhiều cây quyết định, Random Forest có thể bắt được những mối liên hệ phức tạp kiểu này tốt hơn nhiều mô hình đơn giản. Khác với phân biệt classification và clustering, Random Forest hoạt động trong môi trường có nhãn với mục tiêu dự đoán rõ ràng.

Trong nhiều case thực tế, Random Forest cho độ chính xác khá cao và ít bị ảnh hưởng bởi nhiễu. Vì vậy, nó hay xuất hiện trong các bài toán tài chính, y tế, dự báo nhu cầu hay phân tích rủi ro.

Trong quá trình trao đổi và triển khai thực tế, Learning Chain cũng gặp không ít trường hợp Random Forest cho kết quả rất tốt, nhưng không phải lúc nào cũng là lựa chọn phù hợp nhất. Có vài điểm hạn chế mà bạn nên biết trước để tránh dùng sai chỗ.

Random Forest không phải một mô hình, mà là cả một “rừng” cây. Khi số lượng cây nhiều, việc huấn luyện và dự đoán sẽ cần nhiều tài nguyên tính toán hơn. Với dữ liệu lớn hoặc hệ thống có hạ tầng hạn chế, chi phí này có thể trở thành vấn đề.

So với một cây quyết định đơn lẻ, Random Forest cho kết quả tốt hơn nhưng lại khó trả lời câu hỏi “vì sao mô hình chọn phương án này”. Khi cần giải thích cho team business, sếp hoặc khách hàng, việc diễn giải logic bên trong mô hình có thể không đơn giản.

Nếu dùng quá nhiều cây, mô hình có thể trở nên nặng và khó tối ưu cho các bài toán cần phản hồi nhanh, như hệ thống realtime hoặc sản phẩm chạy trực tiếp cho người dùng. Vì vậy, theo góc nhìn của Learning Chain, Random Forest là một công cụ rất tốt khi cần độ ổn định và độ chính xác, nhưng vẫn nên cân nhắc kỹ về hạ tầng, yêu cầu giải thích và tốc độ phản hồi trước khi đưa vào sản phẩm thật.

Các tham số sau mô tả cách Random Forest phân nhánh, kết hợp dữ liệu và giới hạn độ phức tạp của từng cây trong rừng mô hình. Đây là những yếu tố quan trọng trong việc tối ưu thuật toán ensemble learning hiệu quả cho từng bài toán cụ thể.

n_estimators là tham số xác định số lượng cây quyết định trong rừng. Tăng số lượng cây thường cải thiện độ chính xác của mô hình, nhưng cũng làm tăng chi phí tính toán.

max_features là tham số điều chỉnh số lượng đặc trưng ngẫu nhiên được chọn tại mỗi nút phân chia trong cây. Một giá trị nhỏ sẽ làm cây đơn giản hơn và ít phức tạp, nhưng có thể làm giảm độ chính xác.

max_depth là tham số điều chỉnh độ sâu tối đa của mỗi cây quyết định. Cây càng sâu, mô hình càng phức tạp và có khả năng overfitting cao, nhưng có thể cải thiện độ chính xác đối với dữ liệu phức tạp.

min_samples_split là số lượng mẫu tối thiểu tại mỗi nút phân chia để cây có thể tiếp tục phân tách. Một giá trị cao sẽ giúp cây giảm độ phức tạp và giảm nguy cơ overfitting.

min_samples_leaf là số lượng mẫu tối thiểu cần có tại mỗi lá. Tham số này giúp kiểm soát độ sâu của cây và giảm thiểu overfitting.

Khi làm việc với Random Forest, không chỉ dừng ở việc chọn mô hình rồi huấn luyện là xong. Trong thực tế, Learning Chain nhận thấy có một vài kỹ thuật đơn giản nhưng rất hiệu quả giúp mô hình chạy ổn định hơn và cho kết quả tốt hơn, nhất là khi dữ liệu bắt đầu phức tạp.

Thay vì để mỗi cây quyết định nhìn toàn bộ đặc trưng, Random Subspace Method cho mỗi cây chỉ học trên một phần đặc trưng được chọn ngẫu nhiên. Cách làm này giống như việc mỗi người trong nhóm chỉ tập trung vào một vài góc nhìn riêng, thay vì ai cũng nhìn toàn cảnh giống nhau. Nhờ vậy, các cây trong rừng bớt giống nhau, giảm sự phụ thuộc lẫn nhau và kết quả tổng hợp cuối cùng thường ổn định hơn.

Một cách quen thuộc để cải thiện độ chính xác là tăng số lượng cây trong rừng. Khi có nhiều cây hơn, Random Forest thường đưa ra dự đoán chắc chắn hơn vì ý kiến được tổng hợp từ nhiều góc nhìn. Tuy nhiên, Learning Chain thường nhấn mạnh rằng hiệu quả này sẽ chậm dần sau một ngưỡng nhất định. Tăng cây quá nhiều có thể khiến mô hình nặng hơn, tốn tài nguyên hơn nhưng độ chính xác chỉ cải thiện rất ít.

Tóm lại, tối ưu Random Forest không phải là làm cho mô hình càng phức tạp càng tốt, mà là tìm điểm cân bằng giữa độ chính xác, độ ổn định và chi phí tính toán. Trong một số trường hợp phức tạp, kết hợp random forest và bayesian còn giúp ước lượng độ không chắc chắn của dự đoán một cách có hệ thống. Đây cũng là tinh thần mà Learning Chain luôn hướng tới khi áp dụng mô hình vào bài toán thực tế.

Khi nói về Random Forest, tụi mình ở Learning Chain hay nhắc nhau một điều: mô hình này không phải kiểu “nghe cho oai”, mà là thứ rất hay được dùng vì… nó làm việc khá bền và ít gây rắc rối. Ở nhiều bài toán ngoài đời, nơi dữ liệu vừa nhiều vừa lộn xộn, Random Forest thường là lựa chọn an toàn để bắt đầu.

Random Forest xuất hiện khá nhiều ở những bài toán phân tích ảnh cơ bản. Ví dụ trong y tế, thay vì chỉ nhìn ảnh X-quang hay MRI bằng mắt thường, hệ thống có thể trích xuất các đặc trưng từ ảnh rồi đưa vào mô hình để hỗ trợ phát hiện khối u hay vùng bất thường. Nó không thay bác sĩ ra quyết định, nhưng giúp bác sĩ có thêm một góc nhìn từ dữ liệu.

Với hồ sơ bệnh nhân, dữ liệu thường không gọn gàng và mỗi người lại khác nhau. Random Forest có thể gom nhiều yếu tố như tuổi, chỉ số xét nghiệm, tiền sử bệnh, thói quen sinh hoạt… để ước lượng rủi ro hoặc phân nhóm bệnh nhân. Nhờ vậy, bác sĩ có thể sớm nhận ra những trường hợp cần theo dõi kỹ hơn, thay vì đợi đến khi vấn đề trở nên rõ ràng.

Ở ngân hàng hay công ty tài chính, Random Forest thường được dùng để đánh giá rủi ro. Mô hình có thể học từ lịch sử giao dịch để nhận diện nhóm khách hàng vay vốn tiềm ẩn rủi ro cao trong ứng dụng random forest trong credit scoring, hoặc hỗ trợ dự báo biến động thị trường một cách chính xác hơn. Điểm hay là nó không dựa vào một dấu hiệu duy nhất, mà nhìn tổng thể từ nhiều yếu tố cùng lúc.

Random Forest cũng hay được dùng để đọc “tâm trạng” của khách hàng thông qua đánh giá, bình luận hoặc phản hồi. Mô hình giúp phân loại nội dung thành tích cực, tiêu cực hay trung tính, từ đó doanh nghiệp hiểu nhanh xem khách hàng đang hài lòng hay gặp vấn đề gì, thay vì phải đọc thủ công hàng nghìn phản hồi.

Ở các hệ thống thanh toán, Random Forest đóng vai trò như một lớp cảnh báo sớm trong phát hiện gian lận bằng random forest. Khi có giao dịch diễn ra ở vị trí lạ, số tiền bất thường hoặc thời điểm không quen thuộc, mô hình có thể gắn cờ để kiểm tra thêm trước khi rủi ro trở nên nghiêm trọng. Điều này giúp giảm rủi ro trước khi sự cố trở nên nghiêm trọng.

Trong nhà máy, dữ liệu từ cảm biến máy móc được dùng để dự đoán sự cố. Random Forest có thể học từ các tín hiệu rung động, nhiệt độ hay áp suất để cảnh báo sớm nguy cơ hỏng hóc. Nhờ vậy, doanh nghiệp chủ động bảo trì thay vì đợi máy hỏng rồi mới xử lý.

Cùng Learning Chain tìm hiểu các bước quan trọng để xây dựng một mô hình Random Forest hoàn chỉnh – từ chuẩn bị dữ liệu đến đánh giá kết quả. Mỗi bước đều ảnh hưởng trực tiếp đến độ chính xác và khả năng tổng quát của mô hình.

Trước khi nghĩ đến thuật toán, việc quan trọng nhất vẫn là dữ liệu. Dữ liệu ngoài đời hiếm khi sạch sẵn, nên bước đầu tiên luôn là rà soát lại toàn bộ tập dữ liệu: có thiếu giá trị không, có cột nào đang ở dạng chữ cần chuyển sang số không, các đặc trưng có bị lệch thang đo quá nhiều không.

Làm tốt bước này giúp mô hình học ổn định hơn và tránh những sai lệch không đáng có ngay từ đầu.

Khi dữ liệu đã sẵn sàng, lúc này mới bắt đầu tạo mô hình. Random Forest cho phép mình kiểm soát khá nhiều thứ, như số lượng cây trong rừng, độ sâu của mỗi cây hay số lượng mẫu tối thiểu để chia nhánh. Ở giai đoạn này, tụi mình thường chọn các giá trị vừa phải để mô hình không quá phức tạp, rồi tinh chỉnh dần sau, thay vì cố tối ưu ngay từ đầu.

Mô hình sẽ học từ dữ liệu huấn luyện bằng cách tạo ra nhiều cây quyết định khác nhau. Mỗi cây nhìn dữ liệu theo một góc riêng: dữ liệu được lấy ngẫu nhiên, đặc trưng cũng được chọn ngẫu nhiên khi chia nhánh. Chính sự khác nhau này giúp cả “khu rừng” không bị lệ thuộc vào một góc nhìn duy nhất, từ đó giảm overfitting và tăng khả năng tổng quát khi gặp dữ liệu mới.

Sau khi huấn luyện xong, mô hình được kiểm tra trên tập dữ liệu chưa từng thấy. Lúc này, các chỉ số như độ chính xác tổng thể, khả năng phân loại đúng từng nhóm hay mức độ cân bằng giữa precision và recall sẽ cho biết mô hình đang làm tốt tới đâu.

Nếu kết quả chưa ổn, mình quay lại điều chỉnh tham số, dữ liệu hoặc cách tiền xử lý, rồi huấn luyện lại.

Nhìn tổng thể, triển khai Random Forest không phải là một bước “bấm nút là xong”, mà là quá trình thử – quan sát – điều chỉnh liên tục. Chính cách làm này giúp Random Forest trở thành một thuật toán rất đáng tin trong nhiều bài toán thực tế, từ y tế, tài chính cho tới sản xuất.

Từ góc nhìn của Learning Chain, Random Forest là lựa chọn phù hợp khi bạn cần một mô hình ổn định, dễ triển khai và đủ mạnh để xử lý dữ liệu phức tạp, đặc biệt ở những giai đoạn đầu của dự án Machine Learning.

CÂU HỎI THƯỜNG GẶP

Vì sao Random Forest thường cho kết quả ổn định hơn một cây quyết định đơn lẻ?

Vì nó không đặt niềm tin vào một góc nhìn duy nhất. Nhiều cây cùng học, cùng bỏ phiếu giúp mô hình bớt lệch khi dữ liệu nhiễu hoặc không hoàn hảo.

Random Forest học dữ liệu theo cách nào mà lại giảm overfitting?

Mỗi cây chỉ thấy một phần dữ liệu và một phần đặc trưng. Nhờ vậy, các cây khác nhau thật sự, không cùng mắc một kiểu sai lầm.

Khi nào Random Forest không phải lựa chọn lý tưởng?

Khi cần giải thích rất rõ “vì sao mô hình quyết định như vậy” hoặc hệ thống đòi hỏi phản hồi cực nhanh. Lúc đó mô hình đơn giản hơn có thể phù hợp hơn.